TL;DR

Open-Source-LLMs entwickeln sich rapide weiter und erreichen zunehmend ein Leistungsniveau, das mit Closed-Source-Modellen wie GPT-4 vergleichbar ist. Während große Modelle wie DeepSeek R1 (671B) beeindruckende Ergebnisse liefern, setzen sie leistungsstarke Hardware voraus. Kleinere Modelle wie Phi-4 (14B) sind hingegen ressourcenschonender, weisen aber teilweise qualitative Einschränkungen auf. Trotzdem: die Leistungsfähigkeit ist beachtlich und kann mittlerweile für manche Use-Cases als „Production-Ready“ bezeichnet werden. Unternehmen mit hohen Datenschutzanforderungen oder langfristigen Kostenüberlegungen sollten Open-Source-LLM Alternativen unbedingt in ihre Evaluierung aufnehmen.

Analyse: Wie leistungsfähig sind aktuelle Open-Source-LLMs?

Der Markt für Open-Source-KI wächst stetig. Während proprietäre Modelle wie GPT-4 oder Claude weit verbreitet sind, gewinnen Open-Source-LLMs zunehmend an Bedeutung. Jüngste Benchmarks zeigen, dass Modelle wie DeepSeek R1 (671B) in puncto Reasoning und Antwortqualität konkurrenzfähig sind – allerdings bestehen Herausforderungen hinsichtlich Hardware-Anforderungen und Sprachunterstützung. Gleichzeitig gibt es stets kleinere Modellvarianten mit reduzierter Parameteranzahl, die schneller laufen, jedoch qualitative Einbußen in Kauf nehmen müssen.

Eine zweite wichtige Stellschraube beim Austarieren von Geschwindigkeit und Qualität ist die Frage, ob man ein dediziertes Reasoning-Modell wählt oder nicht. Reasoning-Modelle investieren mehr Rechenzeit, um Kontext und Zusammenhänge tiefer zu analysieren, was meist zu besseren Ergebnissen führt, aber auch mehr Ressourcen beansprucht. Nicht-Reasoning-Modelle liefern dagegen schnelle Antworten, können jedoch in komplexen Aufgabenfeldern an ihre Grenzen stoßen. Entscheidend ist also stets die Abwägung zwischen Antwortqualität und Antwortzeit.

Leistungsfähigkeit: Open-Source vs. proprietäre KI

Unser Testlauf mehrerer Open-Source-LLMs, darunter DeepSeek R1, Phi-4 (14B) und verschiedene Llama-Modelle, ergab:

- DeepSeek R1 (671B): Liefert detaillierte und gut strukturierte Antworten, erfordert jedoch High-End-GPUs.

- DeepSeek V3 (671B): Nicht ganz so leistungsfähig wie R1, aber deutlich schneller, da es direkt antwortet, statt zuerst nachzudenken.

- Phi-4 (14B): Schnell und ressourcenschonend, allerdings mit leichten Grammatikproblemen und eingeschränkter Genauigkeit. Momentan unser klarer „Preis-Leistungs-Sieger“.

- Llama 3.2 (3B) & Llama 3.1 (8B): Schnelle Modelle mit geringerem Speicherbedarf, jedoch qualitativ nicht auf demselben Niveau. Nicht zu empfehlen.

Große Modelle liefern überzeugende Ergebnisse, sind aber aufgrund der benötigten Hardware nicht für jeden Anwendungsfall geeignet. Kleinere Modelle sind für den Betrieb auf Standard-Hardware besser geeignet, können jedoch qualitativ nicht mithalten.

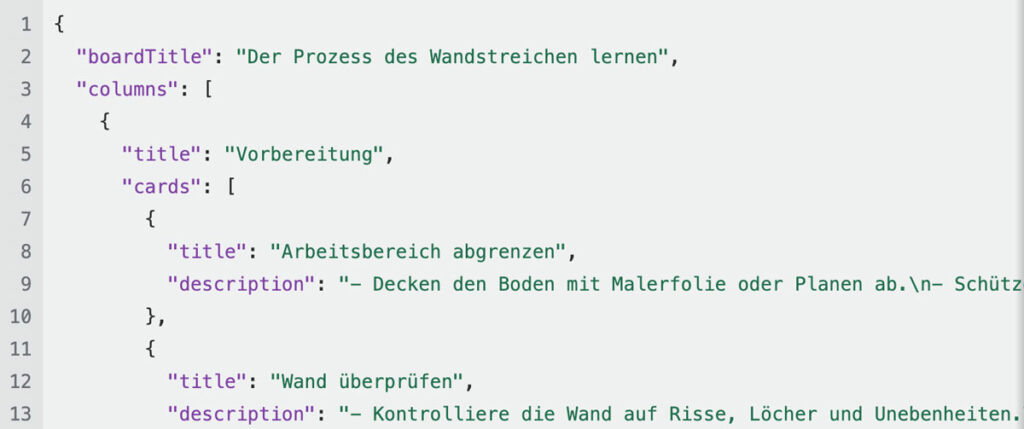

Beispiel 1: Phi-4 hat geringfügige Grammatikprobleme. Außerdem ist der Inhalt simpel. Trotzdem sehr beeindruckend für die Geschwindigkeit.

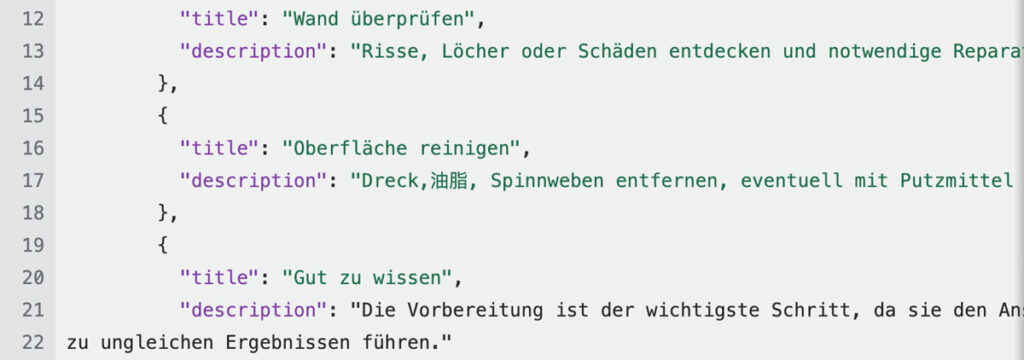

Beispiel 2: DeepSeek R1 zeigt starkes Reasoning. Kleinere Modelle haben aber noch deutliche Schwächen in der deutschen Sprache und mischen manchmal chinesische Begriffe ein.

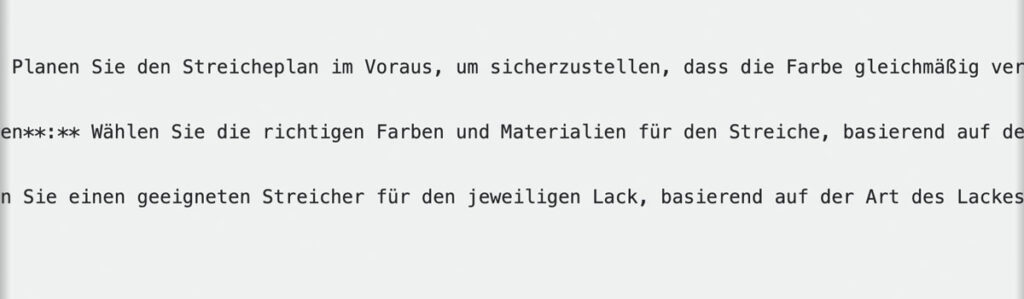

Beispiel 3: Kleinere Llama-Modelle (z. B. Llama 3.1und 3.2) hatten deutliche Schwierigkeiten mit der deutschen Grammatik. Dies lässt jedoch keine Rückschlüsse auf die Qualität größerer Llama-Varianten zu, die hier nicht getestet wurden.

Hardware-Anforderungen: Was wird benötigt?

Ein entscheidender Faktor bei der Nutzung von Open-Source-Modellen ist die benötigte Rechenleistung. Diese bestimmt nicht nur, ob ein Modell überhaupt betrieben werden kann, sondern beeinflusst maßgeblich auch die Geschwindigkeit der Antwortgenerierung. Während Cloud-basierte KI-Dienste diese Rechenleistung direkt bereitstellen, müssen Unternehmen für lokale Infrastrukturen entsprechend in leistungsfähige Hardware investieren:

- DeepSeek R1 (671B): Erfordert High-End-GPUs mit großem VRAM (z. B. NVIDIA A100 oder 4090).

- Phi-4 (14B): Läuft auf leistungsfähigen Consumer-GPUs wie einer RTX 3090 oder 4080.

- Llama 3.2 (3B): Kann auf Mittelklasse-GPUs betrieben werden, bietet jedoch nur eingeschränkte Qualität.

Für Ihr Unternehmen bedeutet dies: Eine einmalige Investition in Hardware kann langfristig kosteneffizienter sein als fortlaufende API-Gebühren, erfordert aber entsprechendes Know-how im Betrieb der Modelle sowie ein „ Commitment”.

Einsatzmöglichkeiten: Wann lohnt sich ein Open-Source-LLM?

Obwohl proprietäre Modelle aktuell einfacher in bestehende Systeme integriert werden können, bieten Open-Source-Alternativen Vorteile:

Datenschutz & Compliance: Gerade für Branchen mit hohen Datenschutzanforderungen (z. B. Gesundheitswesen) kann der lokale Betrieb einer KI zur besseren Einhaltung regulatorischer Vorgaben beitragen.

Kostenersparnis: Während die GPT-4 API-Kosten von mehreren hundert oder tausend Euro verursachen kann, ermöglicht eine Einmalinvestition in Hardware langfristige Einsparungen.

Anpassbarkeit: Open-Source-LLMs können individuell trainiert, optimiert und flexibel in der Modellgröße gewählt werden – ideal, um beispielsweise für einfache Aufgaben schnellere Ergebnisse zu erzielen. Zusätzlich vermeiden Unternehmen durch den Einsatz von Open-Source-Modellen eine starke Abhängigkeit von einem einzelnen Anbieter und können bei Bedarf unkompliziert auf den jeweils aktuell leistungsfähigsten Anbieter wechseln.

Allerdings gibt es auch Herausforderungen:

Technische Einstiegshürde: Der Betrieb und die Wartung eines eigenen Modells erfordern Fachwissen und Erfahrung.

Limitierte Sprachunterstützung: Insbesondere kleinere Open-Source-LLMs sind primär auf Englisch und Chinesisch trainiert. Dies führt in deutschsprachigen Anwendungen häufig zu Qualitätseinbußen, wie oben in den Beispielen deutlich wurde. Größere Modelle sind von diesem Problem in der Regel aber weniger stark betroffen.

Fazit

Open-Source-KI-Modelle sind heute leistungsfähiger denn je und stellen für viele Unternehmen eine ernsthafte Alternative zu Closed-Source-Modellen dar. Wer langfristig auf Datenschutz und Kostenkontrolle setzt, sollte Open-Source-LLM evaluieren. Besonders für spezifische Anwendungsfälle mit lokaler Verarbeitung kann ein maßgeschneidertes Modell vorteilhaft sein.

Darüber hinaus eröffnen sich Ihnen durch das selbstständige Deployen von LLMs völlig neue Möglichkeiten: Die Modellgröße lässt sich flexibel an Ihre Leistungs- und Qualitätsanforderungen anpassen, Datenschutzbestimmungen können besser eingehalten werden und kleinere Modelle lassen sich bei Bedarf sogar auf Consumer-Hardware ausführen.

Klingt nach einem relevanten Anwendungsfall für Sie? Lassen Sie uns ins Gespräch kommen und gemeinsam die für Sie beste Lösung entwickeln.