In den letzten 10 Jahren hat sich der Bereich der künstlichen Intelligenz und insbesondere des Machine Learnings, einer seiner Untergruppen, stark weiterentwickelt. Das Aufkommen neuer Techniken wie Deep Learning und die gemeinsamen Bemühungen, Open Source-Communities, Frameworks und Bibliotheken aufzubauen, haben alle zur Weiterentwicklung der KI beigetragen.

In jüngerer Zeit hat Natural Language Processing (NLP), eine Subdomäne, welche sich dem Verständnis von Textinhalten widmet, auch von neuen Architekturen wie den „Transformatoren“ profitiert. Mit diesen können leistungsstarke Sprachmodelle erstellt und leicht für unterschiedlichste Zwecke wie zum Beispiel Übersetzungen, Stimmungsanalysen und Textklassifizierungen wiederverwendet werden.

Für SPRYLAB war es daher völlig logisch, innovative Funktionen zu entwickeln und anzubieten, mit denen Verlage diese jüngsten Entwicklungen nutzen können. Aus diesem Grund haben wir begonnen, an einer Reihe von APIs zu arbeiten, die die Grundlage für unser Purple DS ACM-Angebot (Autonomous Content Management) bilden. Wir haben uns entschieden, Empfehlungssysteme, Artikelverknüpfungen und Themenmodellierung (TP) als erste Anwendungsfälle für die Erstellung unserer ACM-Lösung zu wählen. Sehen wir uns diese Anwendungsfälle genauer an.

Anwendungsfall 1: Empfehlungssystem

Als digitaler Verlag stehen Sie ständig vor der Herausforderung, ein loyales Online-Publikum für den Aufbau einer erfolgreichen Marke zu gewinnen. Der beste Weg, um dieses Problem zu lösen, besteht darin, wirkungsvolle und personalisierte Inhalte bereitzustellen, die den Benutzer beschäftigen. Empfehlungssysteme (Englisch Recommender System, RecSys) verbessern die Benutzererfahrung, erhöhen die Seitenaufrufe und verbessern das Site-Ranking. RecSys sind sehr beliebt und werden viel recherchiert. Sie können allein oder zusammen mit verschiedenen Ansätzen implementiert werden. Am beliebtesten sind die inhaltsbasierte und die kollaborative Filterung.

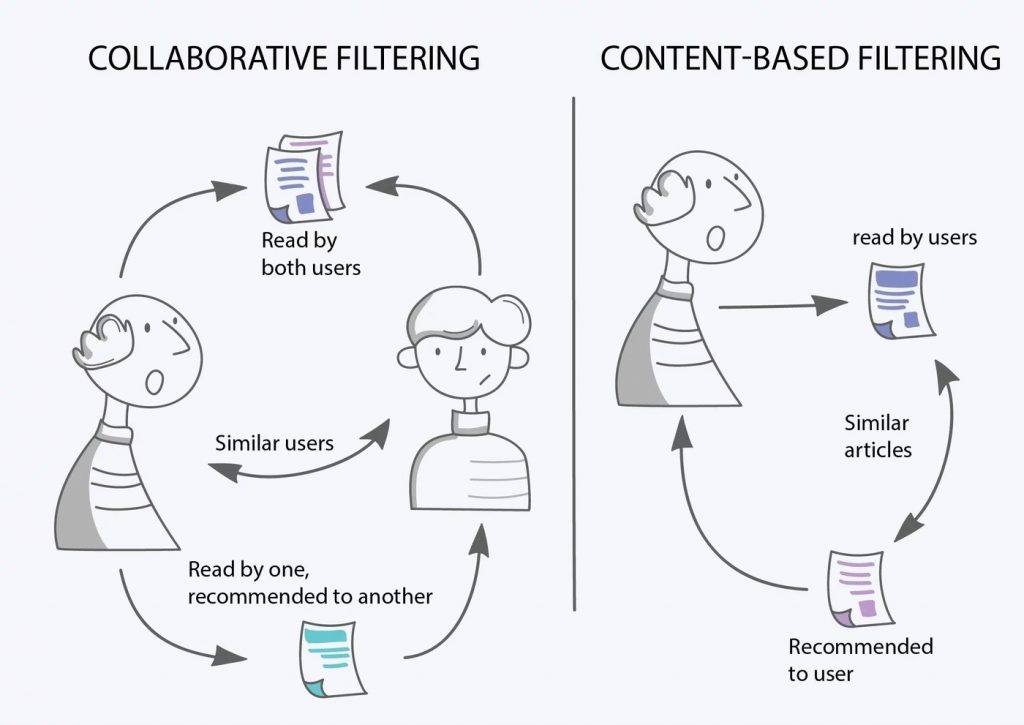

Inhaltsbasierte Filterung

Inhaltsbasierte Filterung ist eine Technik, die analysiert, was eine bestimmte Person liest, und dann versucht, ähnliche Inhalte zu priorisieren. Dies bedeutet, dass empfohlene Artikel auf Grundlage der Lesegeschichte an die persönlichen Vorlieben angepasst werden. Um die Präferenz eines Benutzers definieren zu können, müssen wir in der Lage sein, zu identifizieren, welche Informationen (in ML häufig als Features bezeichnet) verwendet oder aus den Artikeln abgeleitet werden können, an denen die Leser interessiert sind. In unserem Fall sind Features wie Kategorie, Unterkategorie oder verfeinerte Themen verfügbar oder könnten von anderen NLP-Techniken abgeleitet werden.

Kollaborative Filtering

Kollaborative Filterung ist eine Technik, die nicht nur die Artikelpräferenzen einer Person berücksichtigt, sondern auch die Daten anderer Leser mit ähnlichen Präferenzen. Im Vergleich zur inhaltsbasierten Filterung ist die Vielfalt der Inhalte, die dem Leser empfohlen werden können, viel höher. Darüber hinaus ist es nicht erforderlich, die Ähnlichkeit zwischen verschiedenen Artikeln zu berechnen.

Ensemble Learning

Wie bei vielen maschinellen Lernsystemen steigt die Genauigkeit, wenn wir die Ergebnisse verschiedener Modelle kombinieren. Diese Technik nennt man Ensemble Learning. Wir implementieren ein solches Hybridsystem in unserem RecSys.

In Bezug auf die Implementierung ist es äußerst wichtig, über die passende Pipeline für die Datenaufnahme und -transformation zu verfügen, um unsere Modelle trainieren zu können. In der Tat ist die Datenmenge in Bezug auf die Leseranalyse ziemlich bedeutend. Bei SPRYLAB haben wir uns für ein modernes und flexibles Framework entschieden, um diese Aufgaben auszuführen: Apache Beam. Dies ermöglicht uns ein einziges Framework, das sowohl Stream- als auch Batch-Datenpipelines mit derselben API verarbeiten kann. Es ist auch unabhängig von seiner Ausführungsplattform, sodass Sie Ihren eigenen Spark-Cluster verwenden können, falls bereits einer vorhanden ist. Wenn Sie Ihre DevOps-Last reduzieren möchten, können Sie einen Autoscaling-Dienst wie Google Dataflow verwenden.

Um unsere Leistung und Qualität kontinuierlich zu verbessern, prüfen wir verschiedene mögliche Verbesserungspfade:

- Bestimmte Themen, die saisonalem Interesse unterliegen, können leicht erfasst und in unserem Modell wiedergegeben werden.

- Ein Leser kann von einer festen Strategie in Bezug auf Präferenzen betroffen sein. Durch die Verwendung einer geeigneten Verstärkungstechnik können wir möglicherweise ein besseres Gleichgewicht zwischen Erkundung und Ausbeutung finden. Diese Technik besteht darin, verschiedene Strategien mit der richtigen Frequenz abzuwechseln.

Anwendungsfall 2: Artikelverknüpfung

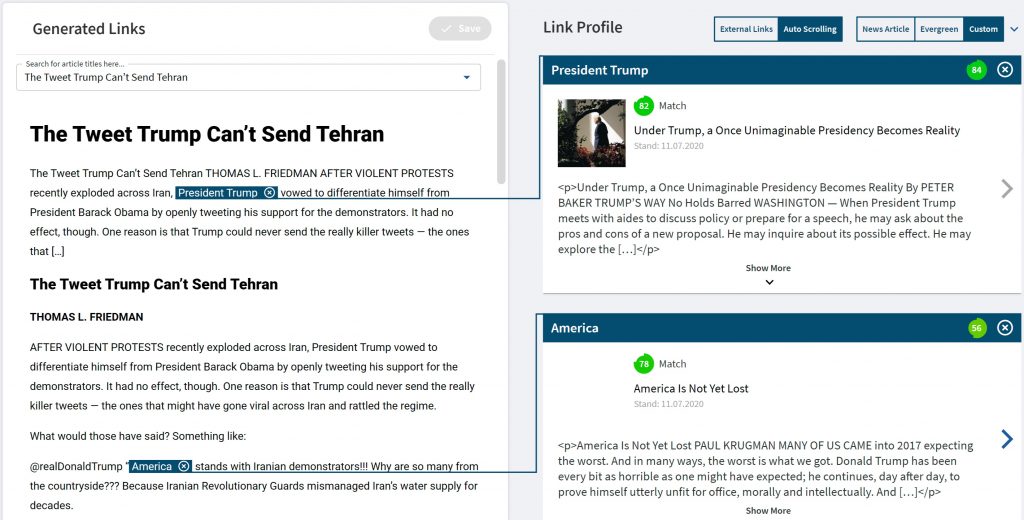

Weitere Ziele, die alle digitalen Verlage gemeinsam haben, sind die Bindung des Publikums und die Erhöhung der Sichtbarkeit durch Verbesserung der Suchmaschinenoptimierung. Dies könnte erreicht werden, indem ein Teil eines Artikels (normalerweise eine Gruppe von Wörtern in einem Satz) entweder mit einem anderen Artikel oder mit einer externen Website verknüpft wird. Traditionell wird diese Aufgabe manuell vom Redakteur ausgeführt. Der gesamte Prozess ist natürlich zeitaufwändig und erfordert viel Wissen. Auch hier kann maschinelles Lernen verwendet werden, um den Redakteur bei dieser Aufgabe zu unterstützen, indem die Generierung potenzieller Linkkandidaten automatisiert wird.

Lassen Sie uns dies etwas weiter aufschlüsseln und sehen, was zu tun ist:

- Für jeden Artikel müssen wir die Textauswahl identifizieren, die als Link verwendet werden kann.

- Für jede Textauswahl muss eine ordnungsgemäße Suche durchgeführt werden, bei der verknüpfte Kandidatenartikel angezeigt werden.

- Eine erneute Einstufung dieser Kandidaten muss berechnet werden.

- Zuletzt wird ein Filter auf die Ergebnisse angewendet, der Konfigurationsparameter wie die Anzahl der Links pro Absatz und den Konfidenzschwellenwert berücksichtigt.

Schritt 1 – Textauswahl

Der erste Schritt ist sehr schwierig, da die Anzahl der ausgewählten Texte sehr schnell unter einer kombinatorischen Explosion leidet. Um dies zu umgehen, besteht unser erster Ansatz darin, nur eine Phrase (eine Gruppe von Substantiven) zu betrachten, die mit dem Ergebnis eines NER-Algorithmus (Named Entity Recognition) gekoppelt ist. Dies reduziert die Anzahl der Suchvorgänge erheblich, hat jedoch den Nachteil, dass Auswahlen generiert werden, die zu allgemein sein können. Wenn eine Auswahl beispielsweise auf „Die EU“ verweist, erhalten wir möglicherweise viele Suchergebnisse, die zwar der Auswahl, aber nicht wirklich dem Kontext entsprechen. Glücklicherweise verfügen wir über einen Datensatz mit kommentierten Auswahlen, mit dem wir ein Modell trainieren können, das eine POS-Tagging-Analyse (Part of Speech) verwendet, um eine größere und angemessenere Auswahl sicherzustellen.

Schritt 2 – Suche nach verknüpfbaren Assets

Da wir Elasticsearch (ES) zum Indizieren unserer Inhaltsressourcen verwenden, ist der zweite Schritt derzeit der einfachste. Sein leistungsstarker Motor liefert gute Ergebnisse, die im nächsten Schritt weiter verfeinert werden.

Schritt 3 – Semantisches Ähnlichkeitsranking

Der dritte Schritt berücksichtigt unter anderem einige vordefinierte Strategieparameter wie Aktualität und Ähnlichkeit mit dem Zielartikel. Der interessanteste Teil stammt aus der Ähnlichkeitsberechnung. Selbst ES kann zwar keine gute Leistung in Bezug auf semantische Ähnlichkeit erbringen, aber hoffentlich können die neuesten Sprachmodelle wie BERT Einbettungen generieren, die dies berücksichtigen. In naher Zukunft werden wir einen Weg evaluieren, diese Einbettungen zu verwenden, um eine effiziente Vektorähnlichkeitssuche durchzuführen, wie hier beschrieben.

Schritt 4 – Finale Rangliste

Auch der letzte Schritt ist recht trivial. Hier werden die Endergebnisse ein letztes Mal anhand einer Reihe zusätzlicher Parameter wie Anzahl der Links pro Absatz, Konfidenzniveau-Schwellenwert, Anzahl der Kandidatenartikel usw. bewertet. Dies hilft, die Anzahl der Links zu reduzieren, die zur Validierung angezeigt werden. Beachten Sie, dass ein Redakteur in unserem Tool, wenn er mit der automatischen Textauswahl nicht zufrieden ist, bei der Auswahl eines beliebigen Textteils weiterhin automatisch relevante Artikel finden kann.

Anwendungsfall 3: Themenmodellierung

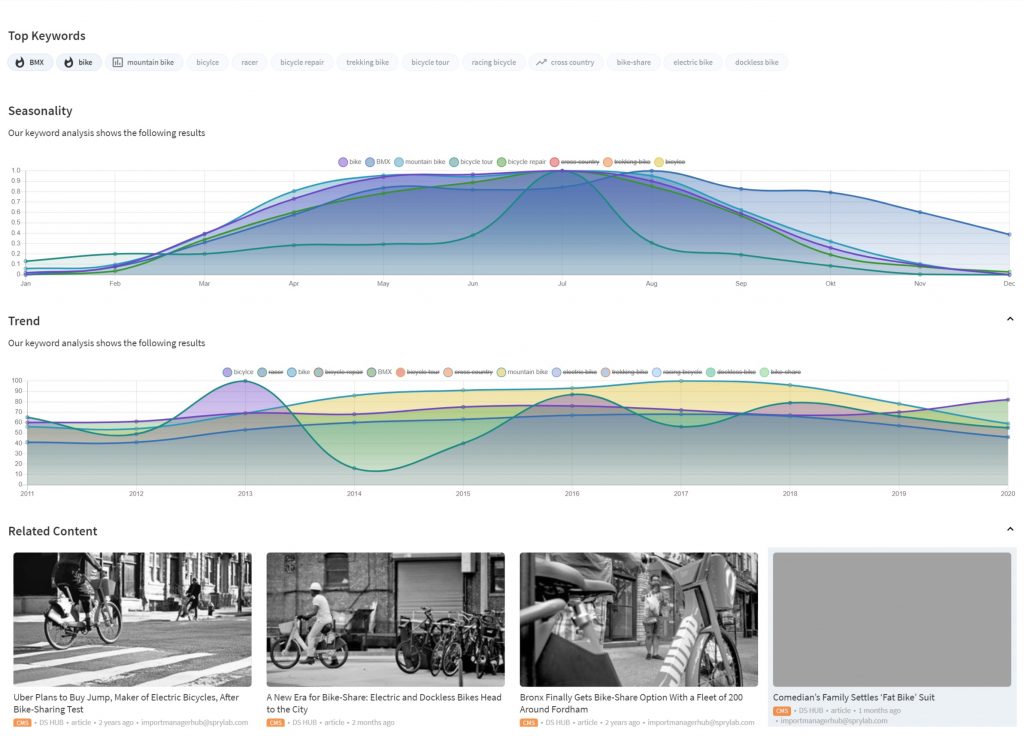

Wir haben Topic Modeling (TP) bereits kurz als Mechanismus zur Merkmalsextraktion erwähnt, der bei der Implementierung einer RecSys-Strategie auf die Content Filtering-Methode angewendet werden kann. Aber natürlich geht seine potenzielle Nutzung weit darüber hinaus.

Als Verlag sind Sie stets bemüht, die Interessen Ihrer Leser zu berücksichtigen und deren Neugier zu wecken. Zu diesem Zweck müssen Sie besonders auf Ihre Redaktion und die globale Abdeckung von Themen achten, die Sie integrieren möchten.

Interessante Themen können in zumindest zwei Kategorien unterteilt werden:

- Saisonale Themen, bei denen es sich um wiederkehrende Inhalte handelt, die „angesprochen“ werden müssen, z. B. Ereignisse wie Weihnachten oder die Sommerferien.

- Heiße Themen, bei denen es sich um aktuelle oder aufkommende Themen handelt, welche normalerweise nicht behandelt werden, die aber mit Ihren Inhalten verknüpft sind.

Wir haben uns daher entschlossen, uns auf diese Art von TP zu konzentrieren, die Redakteure bei der Auswahl des richtigen Themas zum richtigen Zeitpunkt unterstützen und ihnen helfen, ihren redaktionellen Kalender weit im Voraus planen zu können.

Unüberwachtes Lernen

Aus technischer Sicht verwenden beide TP-Kategorien einen gemeinsamen zugrunde liegenden Mechanismus, nämlich die Schlüsselwortextraktion. In unserem Fall verwenden wir bekannte unbeaufsichtigte Lerntechniken wie Latent Dirichlet Allocation (LDA), um Schlüsselwörter aus unseren Inhaltsdatenbanken zu extrahieren, insbesondere die Implementierung einer beliebten Bibliothek namens Gensim. Zusammenfassend ermöglicht LDA die Extraktion von Schlüsselwörtern, die als Wahrscheinlichkeitsverteilungen von Wörtern interpretiert werden können.

Darüber hinaus bauen wir zwei Hauptdienste auf: Saisonale Themenanalyse und Hot Topic-Analyse.

Für die saisonale Themenanalyse können wir eine zeitliche Analyse für eine bestimmte Liste von Themen durchführen, die wir zuvor berechnet haben. Google Trends bietet uns Einblicke in jedes Keyword, das unsere Themenauswahl steuert.

Für die Hot Topic-Analyse wenden wir eine ähnliche Strategie wie im vorherigen Fall an. Hier verwenden wir die Nachrichtendienst-API Aylien, um eine Trendanalyse der erfassten Nachrichten durchzuführen. Wir können dann die Relevanz der Nachrichten für die Themen beurteilen, auf die sich der Verlag hauptsächlich konzentriert.

In beiden Fällen bieten wir nach Auswahl eines Themas zusätzliche Funktionen in unserem Purple DS-Artikeleditor, um die Übereinstimmung zwischen dem Thema, über das ein Benutzer schreiben soll, und den Zielschlüsselwörtern für das betreffende Thema auf einfache Weise zu bewerten.

Fazit

Obwohl die zweite digitale Transformation mit maschinellen Lernsystemen erst vor kurzem begonnen hat, können wir ihre Annahme bei großen Verlagen und schrittweise schon in der gesamten Branche beobachtet.

Die in diesem Artikel hervorgehobenen Funktionen stellen nur einen Bruchteil dessen dar, was möglich ist. In NLP werden der ständige Fortschritt und das Aufkommen noch leistungsfähigerer Sprachmodelle in Kürze Funktionen wie die Zusammenfassung von Texten oder sogar die Texterzeugung für einige einfachere Fälle ermöglichen. Darüber hinaus kann eine andere ML-Domäne wie Computer Vision problemlos in Verbindung mit NLP verwendet werden, um vorhandene Funktionen wie das Verknüpfen von Inhalten mit Bildanbietern oder das Erstellen neuer Inhalte wie automatische Bilder oder Videoanmerkungen weiter zu verbessern.